Дослідження статистики зображень завжди проводять стосовно до досить вузького класу сюжетів (наприклад, рукописні тексти на фототелеграфним бланках, портрети крупним планом тощо). В цих випадках вдається виділити класи, які можна при рішенні технічних завдань вважати статистично однорідними.

Виміри, зроблені на телевізійних кадрах і кінокадрах, показали, що ймовірності різних градацій яскравості практично мало відрізняються один від одного (Kretzmer, 1952). Якщо розбити інтервал яркостей, наявних у зображенні-від мінімальної Вмин до максимальної Вмакс на т однакових ступенів, рівних

[Вмакс - Вмин]/m,

то можна вважати ймовірність кожної з них приблизно дорівнює рі =1/m. Ентропія, підрахована в цьому першому (так званому одновимірному) наближення, яке ми позначимо G1, буде близька до log m,

(35)

Тут немає переважних градацій, більш ймовірних «символів», як у звичайному алфавіті, де ймовірність одних букв, наприклад «а», «е», «і», у багато разів перевершує ймовірність інших букв, наприклад «е», «ш».

Облік статистичних зв'язків між елементами зображення може бути проведений двома різними способами - методом угруповання і методом передбачення.

При використанні методу групування зображення розбивають на групи елементів, з v в кожній. Підраховують ймовірності (точніше кажучи, частоти), з якими зустрічаються всі можливі групи з v елементів. Якщо кожен з елементів може приймати будь-яку з т градацій, можливо mv груп. Позначимо через Ві i-ю групу (i може приймати значення від 1 до mv), а через р (Bi) - ймовірність появи такої групи. Тоді величину

можна розглядати як v-e наближення до ентропії (на один елемент). Якщо v = l, тобто група складається з одного елемента, ми повертаємося до першого наближення (35). Чим більше v, тим краще враховуються статистичні зв'язки між елементами, тим менше величина Gv. Шеннон (Shannon a. Weaver, 1949) показав, що зі зростанням v величина Gi монотонно убуває, прагнучи в межі до істинного значення ентропії Н.

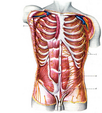

Можна пояснити метод угруповання на прикладі. Снопа звернемося до зображення на рис. 31, а. Ентропія, підрахована в першому наближенні, без урахування статистичних зв'язків з розподілу ймовірностей градацій у відповідності з формулою (35)

G1 = -1/2log21/2 - 1/2log21/2 = 1 дв. од./елемент,

оскільки ймовірність білого шарів дорівнює ймовірності чорного Рчерн. Рбел = Рчерн = 7г (ми як і раніше вважаємо фрагмент зображення на рис. 31, а типовим і вважаємо відносні частоти, з якими зустрічаються різні градації яскравості, рівними відповідним імовірностей). Розіб'ємо тепер зображення на групи по v = 4 елемента, у вигляді квадратів. Всього може бути 24 = 16 таких груп (див. рис. 27). Позначимо їх В1, В2 ... B16, що повинно відповідати 0, 1 ... 15 на рис. 27.

У той час як чорні і білі елементи на рис. 31, а рівноймовірні, деякі з цих груп зустрічаються набагато частіше, ніж інші. Спрощено замінюючи частоти ймовірностями, отримаємо для розподілу ймовірностей табл. 4, * де в першій колонці 1 відповідає чорним, а 0 - білим елементів в групах на рис. 27. Підрахуємо четверте наближення до ентропії за формулою (36)

С4 = - 1,4 (0.43 log2 0.43 + 0.01 log2 0.01 + 0.01 log2 0.01 +... .. + 0.01 log2 0.01 + 0.43 log20.43)≈0.5.

Вийшла величина, яка помітно менше, ніж перше наближення G1. Підрахуємо в цьому наближенні надмірність, підставляючи замість Н в формулу (34) наближене значення G4. Так як в розглянутому випадку Нмакс = 1, то R≈1-0 .5. Отже, можна зменшити інформаційну ємність, що вимагається в середньому для запису зображення розглянутого типу, принаймні на 50% порівняно із звичайним уявленням зображення.

Метод угруповання є, як показали дослідження статистики зображень за допомогою цього методу, недостатньо ефективним. Послідовно одержувані наближення G2, G3, G4 і так далі зазвичай повільно сходяться до своєї межі H. Причину цього легко зрозуміти. Метод угруповання дозволяє врахувати статистичні зв'язки між сусідніми елементами всередині груп. Відносно мала ймовірність переходів і дрібних деталей позначається в тому, що групи з однаковими елементами (В1 і B16 у розглянутому прикладі) зустрічаються значно частіше, ніж групи з великим числом переходів яскравостей від елемента до елемента (наприклад, В7, і В10). Однак статистичні зв'язки між сусідніми елементами, які належать до різних груп, залишаються неврахованими. Між тим при Малому числі елементів в групі ці зв'язки можуть бути настільки ж сильні, як і зв'язки всередині групи. Ймовірність зміни яскравості при переході від одного елемента групи до сусіднього з ним елемента іншої групи не повинна відрізнятися від імовірності зміни яскравості при переході від одного елемента до сусіднього з ним всередині групи.

Повідомлення про яскравості елементи даної групи буде містити менше інформації, коли вже буде відома яскравість сусіднього з ним елемента іншої групи.

Поки значення v невелика, велика частина елементів в групі безпосередньо примикає до елементів сусідніх груп, і те обставина, що статистичні зв'язки між групами не враховані, позначається особливо істотно. Наприклад, при v=4, як у розглянутому випадку, кожен елемент у групі є граничним, і ряд сусідніх із ним елементів належить сусідніх груп.